В 2025 году Nvidia окончательно закрепилась как центральный поставщик вычислительной инфраструктуры для ИИ. Рост спроса на обучение и запуск моделей привел к тому, что чипы для дата-центров стали одним из главных драйверов ее финансовых результатов.

Как результат, Nvidia стала самой дорогой компанией в мире. Для ИИ-отрасли это означало не просто успех одной корпорации, а сигнал к формированию зависимости всей экосистемы от ограниченного числа производителей ускорителей.

Топ-6 компаний по рыночной капитализации. Данные: CompaniesMarketCap.

Топ-6 компаний по рыночной капитализации. Данные: CompaniesMarketCap.

Параллельно усилилось внимание к уязвимостям такой модели. Аналитики и СМИ указывали на узкие места в производственных цепочках, включая технологическую «упаковку» чипов. Речь идет об этапе, на котором вычислительные кристаллы и высокоскоростная память объединяются в единый модуль.

Кроме того, вопросы возникали и в отношении ограниченных мощностей подрядчиков.

В результате обсуждение ИИ все чаще выходило за рамки софта и моделей. Теперь регулярно поднимаются вопросы физического производства, сроков поставок и концентрации рисков.

На этом фоне все больше внимания стали уделять альтернативам GPU от Nvidia. В частности, Google начала активнее продвигать собственные специализированные ускорители — Tensor Processing Units (TPU), изначально разработанные для внутренних нужд компании.

Как отмечает издание The Information, корпорация рассматривает возможность продажи и аренды TPU за пределами Google Cloud. Это сближает ее стратегию с бизнес-моделью Nvidia и создает прямую конкуренцию на рынке ИИ-инфраструктуры.

Эксперты подчеркивают, что ряд передовых моделей, включая разработки Google и Anthropic, уже обучались на TPU, а не на графических процессорах Nvidia.

Интерес к продукту проявляют и другие крупные игроки. По некоторым данным, Meta ведет переговоры с Google о закупках TPU и рассматривает возможность их использования в собственных дата-центрах, начиная с 2026 года.

Разница между TPU Google и GPU Nvidia заключается в архитектуре и назначении.

Первые относятся к классу специализированных интегральных схем (ASIC) и оптимизированы для выполнения конкретных операций. Это делает их более энергоэффективными и экономичными в ряде сценариев, особенно при обучении и запуске моделей, изначально спроектированных под эту архитектуру, таких как Gemini.

В то же время GPU Nvidia остаются более универсальными и выигрывают за счет развитой программной экосистемы CUDA. Она облегчает их использование для широкого круга задач.

Дальнейшее распространение TPU может усилить давление на Nvidia по линии цен и доступности.

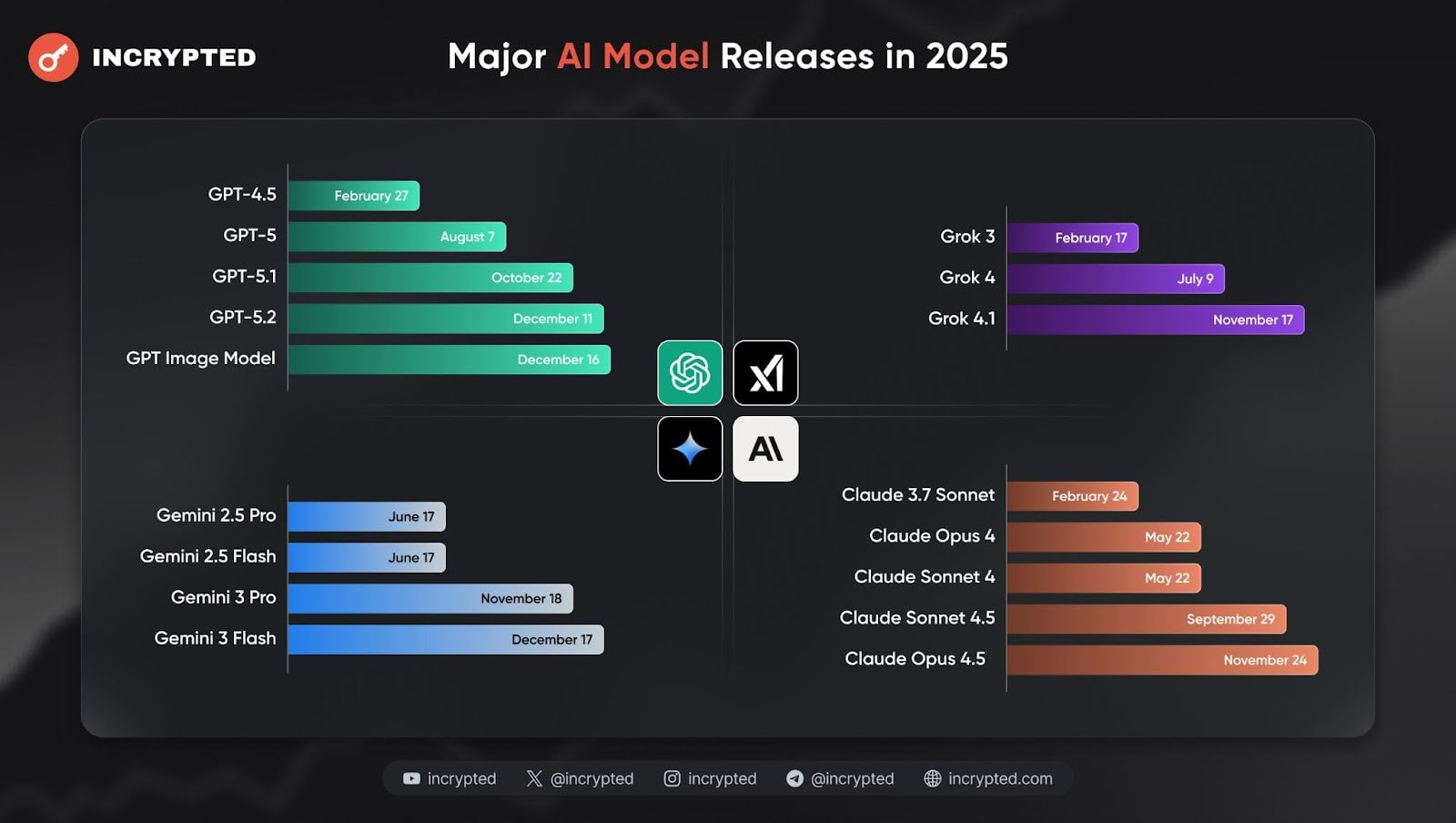

График выхода ИИ-моделей от ведущих разработчиков отрасли. Данные: Incrypted.

График выхода ИИ-моделей от ведущих разработчиков отрасли. Данные: Incrypted.

Топ-6 компаний по рыночной капитализации. Данные: CompaniesMarketCap.

Топ-6 компаний по рыночной капитализации. Данные: CompaniesMarketCap.

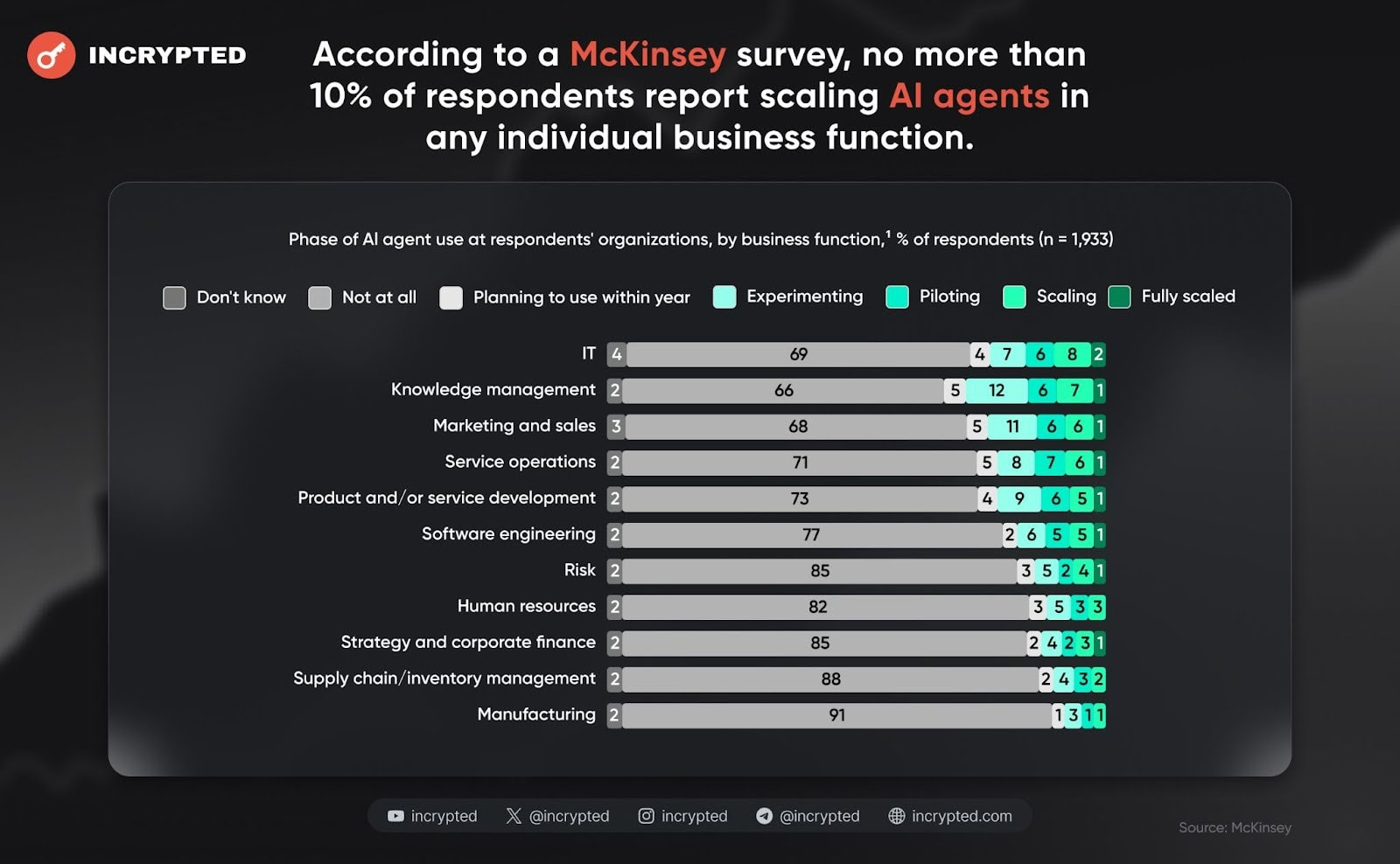

Доля компаний, масштабировавших ИИ-агентов по бизнес-функциям. Данные: McKinsey.

Доля компаний, масштабировавших ИИ-агентов по бизнес-функциям. Данные: McKinsey.

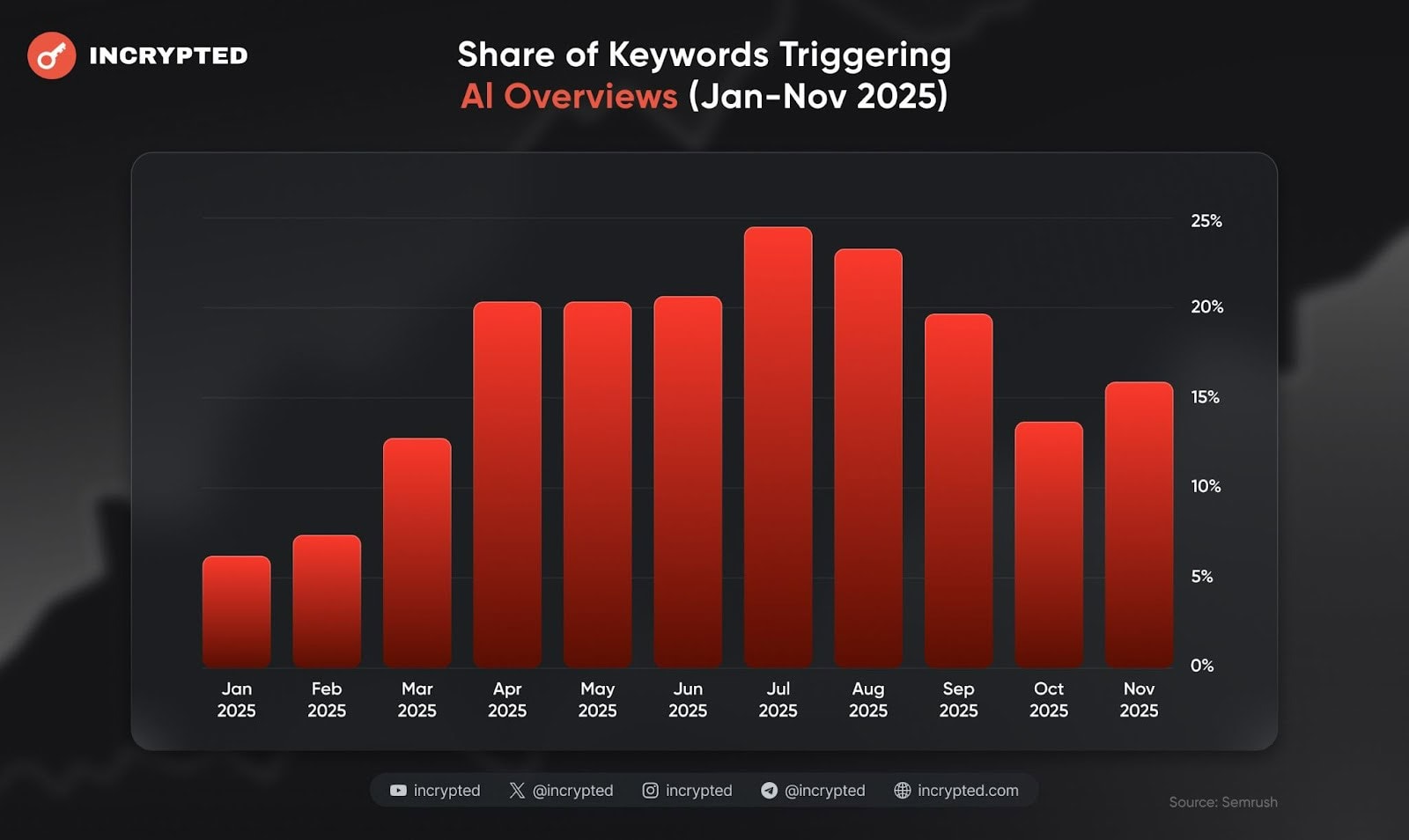

Доля запросов с ИИ-сводками Google в поиске в период с января по ноябрь 2025 года. Данные: Semrush.

Доля запросов с ИИ-сводками Google в поиске в период с января по ноябрь 2025 года. Данные: Semrush.

Рост стоимости комплектов оперативной памяти. Данные: Intuition Labs.

Рост стоимости комплектов оперативной памяти. Данные: Intuition Labs.

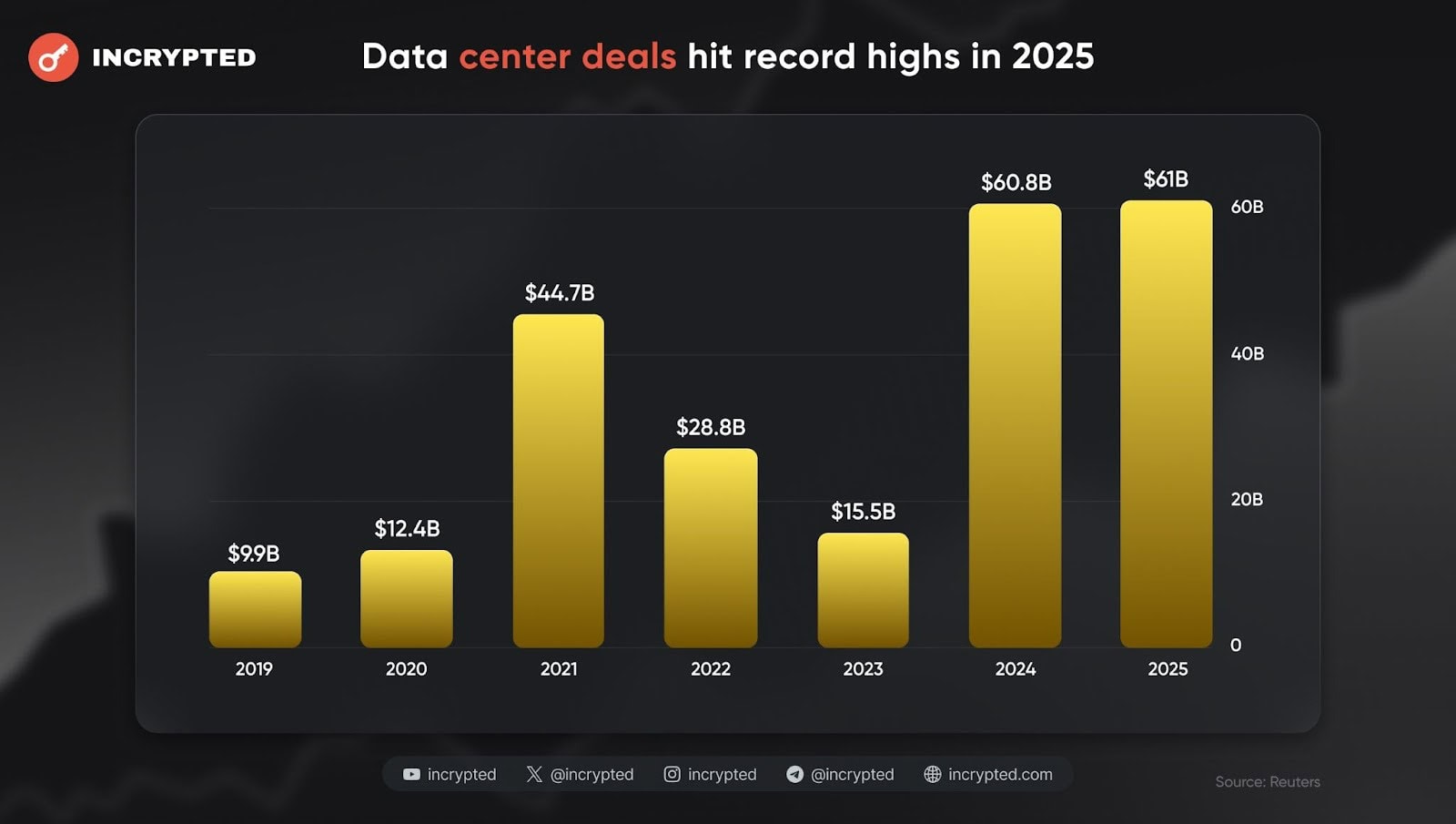

Объем инвестиций в постройку и расширение дата-центров по годам. Данные: Reuters.

Объем инвестиций в постройку и расширение дата-центров по годам. Данные: Reuters.